系统架构

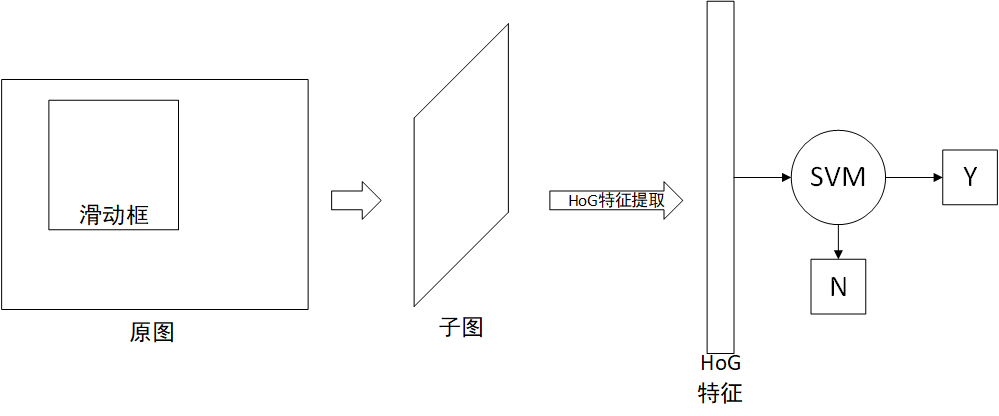

该系统仍然是基于滑动框+传统机器学习的目标识别系统,分为两个主要部分:

- HoG特征提取:从滑动框中提取出的子图中提取HoG特征

- 支持向量机(SVM):以子图的HoG特征为输入,判断该子图中是否有物品

HoG特征

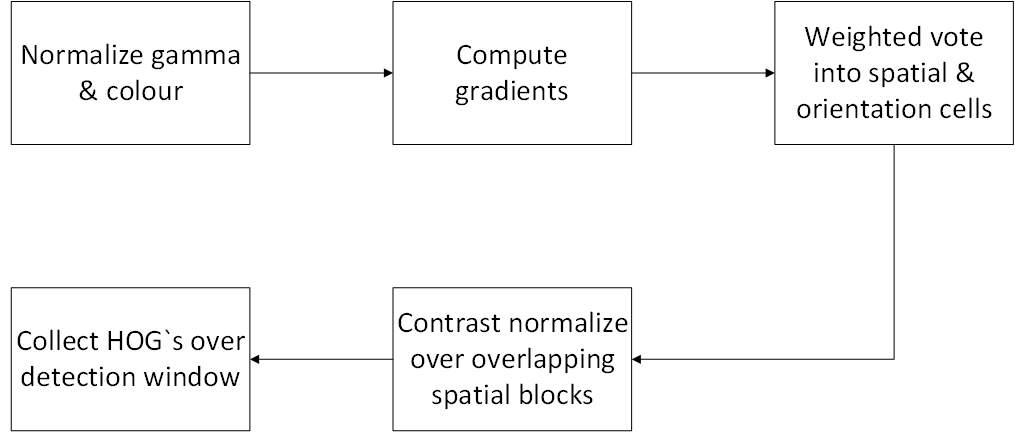

该系统的最大贡献为提出基于梯度的HoG(locally normalized Histogram of Oriented Gradient)特征,该特征的计算流程分为5步,分别如下所示:

归一化

归一化目的是去除光线的影响,gamma校正的公式如下所示:

原论文尝试了多种输入方法,包括灰度图像和彩色图像与是否gamma校正的组合,由于这一步对最终结果影响很小,因此最终默认为使用彩色输入,不进行gamma校正。

梯度计算

梯度的计算使用相邻或不相邻的像素值相减获得,两个方向的梯度和计算出整体梯度的角度和模。原论文尝试了多种计算方法,最终使用的计算方法如下所示:

其中$grad_x(x,y)$和$grad_y(x,y)$的计算方法分别是与及其$[-1,0,1]$转置与这一步的输入图片卷积。若输入图片的输入通道不为1,那么将其所有通道的数据组合到一个向量中。

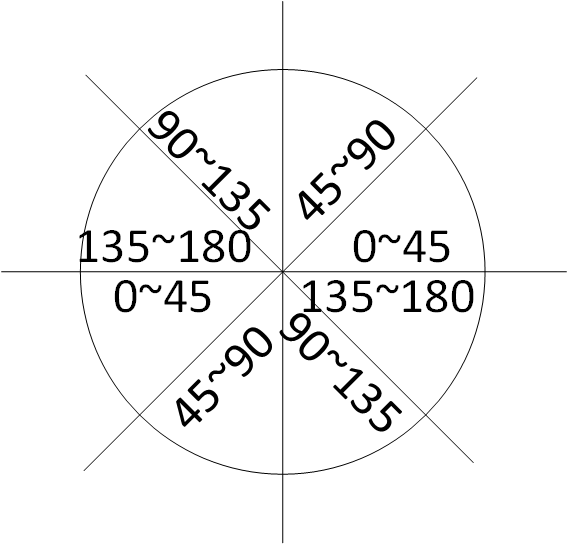

直方特征统计

该步骤是引入非线性的关键步骤,该步骤是基于一种被称为cell的结构,一个cell由一个正方形的块覆盖的像素组成,论文中使用的cell尺寸为4x4。对于一个cell中的所有像素统计一种直方图,该直方图的横轴为梯度方向,纵轴为梯度模,如下图所示:

角度落在相同区间的梯度的模累加,作为该区间的结果。上图为0~180度分为4个区域的划分,最终产生四个数据,分别是角度落在四个角度区域的梯度的模之和。原论文中,角度区域的划分方法对最终结果有一定的影响,最终试验后使用0~180度划分9个区域的划分方法(每个20度),每个cell产生9个数据。

特征归一化

特征的归一化基于block结构,该结构由一些cell组成,分为R-HoG和C-HoG两种。其中R-HoG应用较多,由相邻的构成方形的cell,block可以相互重叠,可以参考重叠的池化。C-HoG的block为圆形,未能找到资料,且论文描述较含糊。属于一个block的所有cell的数据组成一个向量。

标准化中,基于block的标准化使用cell组成的向量标准化,可以使用L2-Hys,L2标准化和带开方的L1标准化。L1与L2标准化如下所示:

其中v为待标准化向量,e为为了防止除0的很小的常数。L2-Hys标准化首先进行L2标准化,对结果进行截短,再进行L2标准化,以上所述的标准化方法对结果影响均不大,论文中使用L2-Hys标准化。

除了这种标准化方式,论文中还提到了基于周围cell的标准化方式,但效果不佳。

组合特征

特征计算完成后,将所有block特征组合为一个向量,该向量即为后端SVM的输入。

SVM(支持向量机)

使用支持向量机判断候选框中是否有物品,支持向量机的输入为组合成向量的HoG特征,输出为是否是待检测物品。

代码实践

1 | import cv2 |